#072 Relevanz der Kontextlänge - Die Nadel im Heuhaufen

Je länger der Kontext wird, desto schwieriger wird es für die KI, eine Information zu finden.

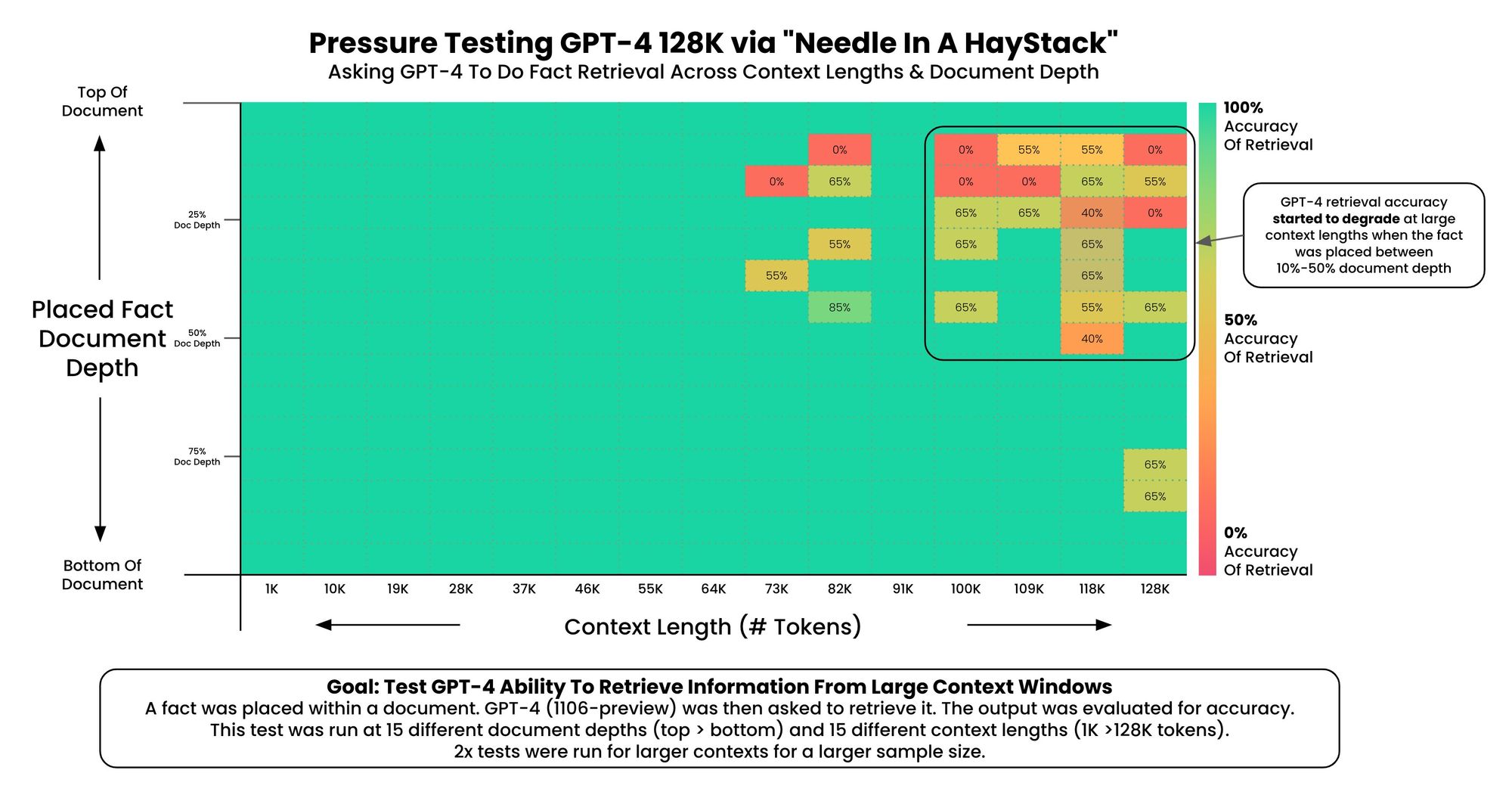

Greg Kamradt hat in einem Test geprüft, wie gut OpenAI mit GPT-4 darin ist, Informationen aus langen Kontexten abzurufen. Insbesondere wurde untersucht, ob die KI eine Tatsache aus einer großen Menge an Text wiederfinden kann (Video siehe unten).

Greg verwendete das neue GPT-4 von OpenAI und variierte die Dokumentenlänge von 750 bis 96.000 Wörter über 250 API-Aufrufe, was 200 Dollar kostete. Dabei wurde untersucht, ob das Modell eine "Nadel im Heuhaufen" finden konnte.

Die Ergebnisse zeigten, dass GPT-4 die Tatsache in Dokumenten mit bis zu 64.000 Tokens genau abrufen konnte. Bei längeren Längen hatte es jedoch Schwierigkeiten, insbesondere wenn die Tatsache am Anfang des Dokuments platziert wurde.

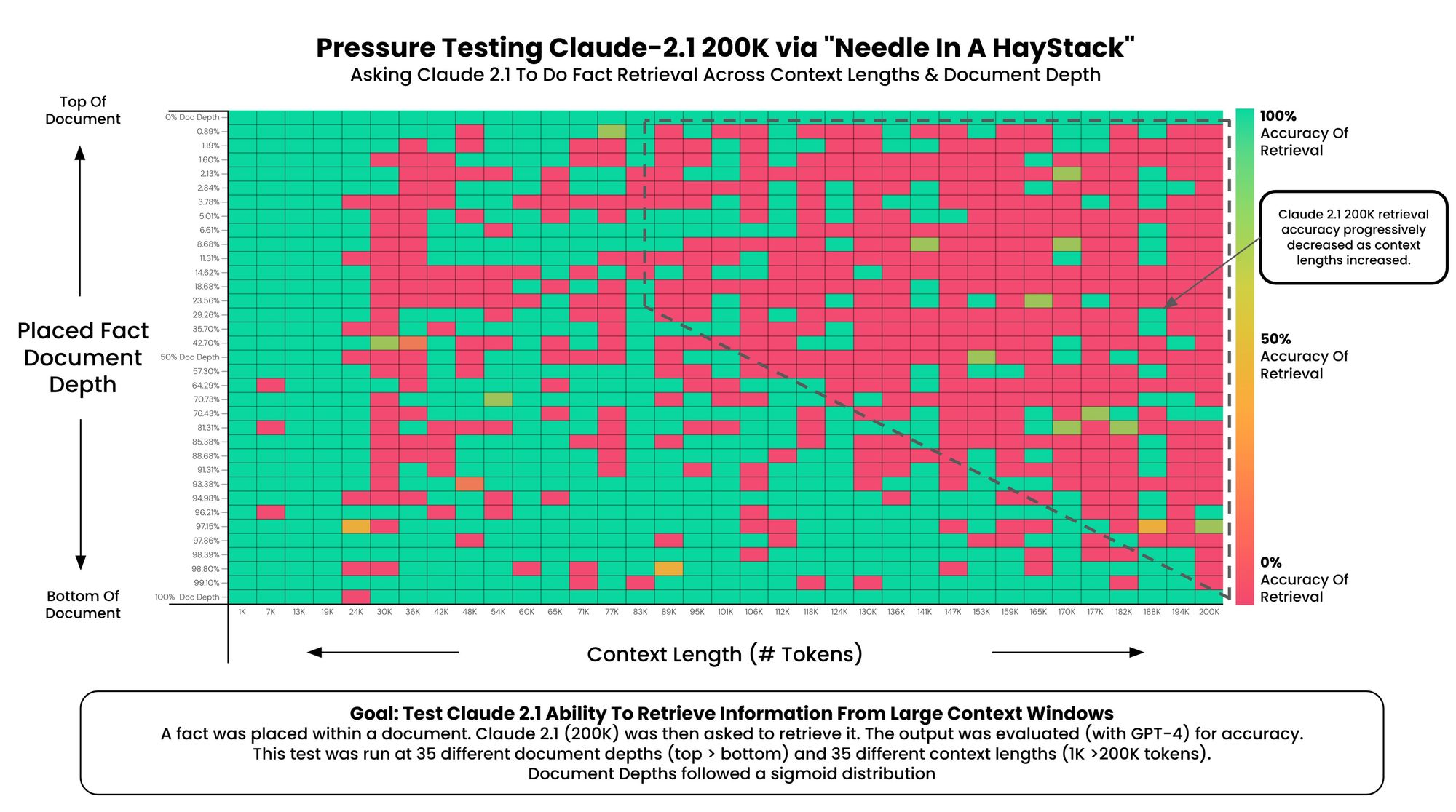

Die Heatmap veranschaulicht die Leistung der KI bei der Informationswiedergewinnung basierend auf der Dokumentenlänge und der Platzierung der Tatsache.

Die gleiche Untersuchung hat er auch für Claude 2 vorgenommen: